Umělá inteligence (Artificial Intelligence, AI) je nejžhavějším tématem posledních let, a to nejen v oblasti technologií. Je všude – od zubních kartáčků po vědecké články. Požívá stovky miliard dolarů, otřásá akciovými trhy, podkopává důvěru v důvěryhodnost digitálního obsahu, vyvolává halucinace a živí apokalyptické předpovědi. Co je AI ve skutečnosti? Měli bychom místo umělé inteligence mluvit o mimozemské inteligenci, jak navrhuje Yuval Noah Harari, nebo očekávat spojení proteinové inteligence s křemíkovou prostřednictvím rozhraní mozek-počítač? Proč se vědecky podložená civilizace náhle obrací k černým skříňkám a tajemným věštcům?

Pokusím se definovat, co je AI, a vysvětlit, co není, a přitom odhalím několik městských legend o odposlouchávání myšlenek a přenosu vědomí do kyberprostoru. Budu také diskutovat o skutečných hrozbách, které vyplývají z toho, že po léta předáváme moc nad svými dušemi algoritmům, ale nevšímáme si toho, protože nasloucháme příběhům o nadcházející apokalypse AI.

Je to AI?

Podle nařízení Evropského parlamentu a Rady (EU) 2024/1689, které vstoupí v platnost 2. února 2025,

„systém AI“ znamená strojový systém, který byl navržen pro provoz s různými úrovněmi autonomie po svém zavedení a který může po svém zavedení prokázat schopnost přizpůsobení, a která – pro výslovné nebo implicitní účely – vyvozuje závěry o tom, jak na základě získaných vstupních údajů generovat výsledky, jako jsou předpovědi, obsah, doporučení nebo rozhodnutí, které mohou ovlivnit fyzické nebo virtuální prostředí […]

Podívejme se na algoritmy a výpočetní metody, které podle všeho odpovídají této definici.

Statistika

Příkladem řešení uvedených v výše uvedené definici může být hodnocení úvěruschopnosti. Úkolem široké třídy statistických metod je určit, zda má být nový klient zařazen do skupiny bonitních nebo nebonitních klientů. Hranice mezi těmito dvěma skupinami se počítá na základě úvěrové historie předchozích klientů banky, která se v jazyce strojového učení označuje jako trénovací vzorek.

Postup jejího stanovení pomocí lineární diskriminační analýzy (linear discriminant analysis, LDA), známé od roku 1936, je poměrně jednoduchý a jednoznačný. Kvalita prognózy závisí výhradně na množství a kvalitě vstupních dat použitých k posouzení hranice mezi skupinami. Po jejím stanovení můžeme rychle a snadno posoudit, do které skupiny bude nový klient pravděpodobně patřit.

Jednoduchý systém, který bude čas od času přidávat data o splácení nedávno poskytnutých úvěrů do trénovacího souboru a znovu vypočítávat hraniční linii pomocí stejného vzorce, splňuje podmínku adaptace po zavedení, generuje rozhodnutí a jeho autonomie závisí výhradně na vůli implementátorů.

Umělé neuronové sítě

Pokud se nechceme omezovat na lineární rozdělení, můžeme použít nelineární analogy LDA nebo například umělé neuronové sítě (artificial neural networks, ANN), které mají nelinearitu zabudovanou v každém z uzlů zpracovávajících informace. Každý uzel na výstupu vrací funkci vážené sumy vstupů; například výstup uzlu D bude roven.

Výpočty v umělé neuronové síti: po zadání hodnot do uzlů A, B a C se podle vzorce ([eq:ann]) vypočítají hodnoty v uzlech D a E a na konci výstupní signál F.

Hypotetická síť hodnotící bonitu

Síť, která hodnotí úvěruschopnost na základě šesti parametrů, může vypadat tak, jak je znázorněno na obrázku výše. Klasifikace nového případu se redukuje na několik použití vzorce ([eq:ann]) – výsledek se odečte z hodnot uzlů poslední vrstvy. Tyto výpočty jsou velmi jednoduché, pokud jsou známy váhy spojení w_xy. Výběr těchto vah pro trénovací sadu je již složitější – algoritmus zpětného šíření je znám již téměř půl století: čas od času, když přicházejí nové údaje, trénujeme síť od začátku a necháme ji generovat řešení.

Hluboké učení

Síť je relativně jednoduchá: pokud známe váhy w_xy, výpočty potřebné pro klasifikaci nového vstupu můžeme provést na listu papíru a dvěma uzlům ve střední („skryté“) vrstvě můžeme dokonce přiřadit hodnoty odpovídající mezistupňům procesu klasifikace.

Vstupní vrstva musí mít velikost odpovídající velikosti analyzovaných obrázků a na výstupu chceme rozlišit 10 tříd (čísla od 0 do 9).

Schéma sítě rozpoznávající ručně psaná čísla

Funkce klasifikace obrázků je zaznamenána v váhách w_xy, proto pro netriviální klasifikaci nemůže být počet těchto parametrů příliš malý. Počet parametrů sítě používaných k rozpoznávání číslic z databáze MNIST (obsahující 60 tisíc příkladů ručně psaných číslic) v přelomové době vzrostl z několika stovek až na milion, přičemž chyby rozpoznávání dosahovaly úrovně zlomků procent.

Milion parametrů je dnes velmi málo – pro klasifikaci složitějších obrázků potřebují neuronové sítě mnohem více parametrů. Čím více parametrů, tím více zdrojů vyžaduje výcvik a provoz sítě a tím složitější je interpretovat jejich význam.

Člověk a umělá inteligence

Boom „skutečně hlubokých“ neuronových sítí začal sítí AlexNet, která se skládala z 650 tisíc uzlů a 60 milionů parametrů. V roce 2012 dosáhla tato síť výsledků, které výrazně překonaly všechny předchozí přístupy v oblasti rozpoznávání obrazů (počítačového vidění). Průlom byl způsoben především dvěma faktory, které zůstávají klíčové dodnes:

- Dostupnost obrovského množství fotografií na internetu, díky čemuž prof. Faye Faye Lee vytvořila sbírku milionů obrázků s popisky obsahu, vhodnou pro řízené učení – ImageNet. Neuronové sítě, trénované na menším množství dat, dosahovaly horších výsledků než klasické metody rozpoznávání obrazů.

- Dostupnost obrovského výpočetního výkonu, zejména specializovaných procesorů pro grafické výpočty (graphical processing units, GPU), jejichž vestavěná paralelita urychlila proces učení sítě a umožnila použití mnohem většího množství parametrů.

Moderní neuronové sítě klasifikují obrázky stejně dobře jako lidé. Příkladem použití, který je v médiích popisován pod sloganem „AI léčí rakovinu“, je detekce nádorů na rentgenových snímcích. Dostatečně velká síť za krátkou dobu učení (tj. nastavení vah w_xy) dokáže prohlédnout více obrázků než radiolog za celý život a dosáhnout „nadlidské“ (nebo expertům vyrovnané) přesnosti. Statisticky.

Při tak obrovských rozměrech sítě je nesmírně obtížné nebo nemožné určit, které vlastnosti obrazů se používají při klasifikaci – o to se zatím bez většího úspěchu snaží oblast zvaná explainable AI. Avšak i při pohledu na sítě jako na černé skříňky lze ukázat, že při klasifikaci se neopírají o stejné charakteristiky obrazů jako lidé. Tento jev ilustrují takzvané útoky jednoho pixelu.

Ukázalo se, že změna jednoho (!) pixelu na rentgenovém snímku zdravého plíce může změnit klasifikaci sítě na „pneumonie“ a naopak. To je ilustrace Moravekova paradoxu: věci, které jsou pro lidi jednoduché, mohou být pro počítače extrémně složité a naopak. Expert na klasifikaci rentgenových snímků využívá veškeré své vzdělání, zkušenosti a porozumění tomu, co je fotografie, zatímco síť se opírá pouze o statistické rozdíly ve skupinách pixelů, což ve většině případů pro klasifikaci stačí.

Generativní AI

Největší vlnu zájmu o AI vyvolalo objevení se internetových rozhraní, která umožňují konverzaci v přirozeném jazyce s velkými jazykovými modely (Large Language Models, LLM). Pro AI se staly tím, čím bylo WWW v posledním desetiletí 20. století pro internet: možnost využívat internetové služby lidem, kteří nemají speciální znalosti a nerozumí principům jejich fungování, vyvolala obrovský nárůst zájmu a investic.

Podobně dnes může každý „mluvit s AI“ a na tomto základě si utvořit vlastní názor. Ukázalo se, že napsání smysluplné eseje LLM, kterou lze předložit jako domácí úkol, udělá mnohem větší dojem než předpověď struktury bílkovin modelem AplhaFold, za kterou byla v roce 2024 udělena Nobelova cena.

Díky chatům s LLM jsou názory na AI většinou nadšené a převládající smysluplnost odpovědí spouští vrozenou sklon lidí k antropomorfizaci. Například naprosté nesmysly, které se čas od času objevují v textech generovaných LLM, nazýváme halucinacemi nebo lží – ačkoli podle autorů článku „ChatGPT is bullshit“ nemají tyto definice smysl v případě bytostí, které neznají pojem pravdy a pouze produkují texty připomínající pravdivá tvrzení. Jsou generovány na základě statistických vlastností textů převzatých z internetu, bez předchozího výběru nebo kontroly. Samotné modely také nemají zabudované mechanismy kontroly pravdivosti, a proto je vědci nazývají stochastickými papoušky.

„Úroveň inteligence AI“ ověřujeme pomocí testů a úkolů, kterých je na internetu dostatek. A opět, v drtivé většině případů, LLM řeší další testy „s nadlidskou přesností“, což se stává důvodem pro zprávy v médiích o tom, že AI právě přešla na novou úroveň – osmiletého dítěte nebo postgraduálního studenta. Extrapolace tohoto trendu na následující roky vede k předpovědím o brzkém konci světa řízeného lidmi atd. Pokud se však podíváme pozorněji, na povrch vyjde rozdíl mezi studentem, který si prostě přečetl sbírku úkolů s odpověďmi, a tím, kdo se alespoň pokusil úkoly vyřešit.

Argumenty poukazující na první situaci, tj. „zapamatování znalostí“, jsou diskutovány v odborných článcích. Například v jednom z nich je uveden výrazný pokles výsledků při malých úpravách standardních testů a úloh – například změnou jmen nebo čísel v textech úloh – což naznačuje, že moderní LLM namísto logického myšlení, které jim je připisováno, reprodukují statistickým výběrem šablon kroky přítomné v trénovacích datech.

Bez ohledu na to, zda tyto procesy považujeme za logické myšlení, nebo ne, nedochází k nim v tak jednoduchých systémech, jako jsou výše popsané ANN – proto již nemluvíme o sítích, ale pouze o modelech. Moderní LLM jsou založeny na architektuře transformátorů (odtud název ChatGPT od Generative Pre-trained Transformer), poprvé popsané v roce 2017 v článku „Attention is all you need“, a mnoha dalších brilantních matematických technikách, jejichž diskuse přesahuje rámec tohoto článku. Jako intuitivní příklad si vezměme techniku učení, která spočívá v tom, že do sítě jsou na vstupu zadávány věty, z nichž je odstraněno (například poslední) slovo, a váhy jsou vybírány tak, aby se právě toto slovo objevilo na výstupu – jakési „autodoplňování na steroidech“, odrážející statistické vlastnosti všech textů světa. Na výstupu model vybírá slova na základě pravděpodobností, ale s prvkem náhodnosti, takže reakce na danou otázku nebude vždy stejná.

Emulace mozku

Výše popsané uzly ANN (umělých neuronových sítí) obvykle nazýváme neurony, což může vést k přehodnocení a nedorozuměním. Co mají ANN a na nich založené AI společného s mozkem?

V roce 1943 ve slavném vědeckém článku „A logical calculus of ideas immanent in nervous activity” Warren McCulloch a Walter Pitts navrhli jednoduchý model neuronu, aby ukázali, že sítě složené z takových jednotek mohou provádět logické operace a výpočty, jako Turingův stroj. Nešlo o simulaci fungování mozku – model byl poměrně volně založen na tehdejších znalostech o nervovém systému a v seznamu literatury byly pouze (tři) práce o formální logice.

Od té doby je rozdíl mezi umělými neuronovými sítěmi a výzkumem a modelováním biologických neuronů pro vědce zřejmý, ale do masové kultury proniká jen málo.

Výpočetní uzly moderních ANN se od verze z roku 1943 liší jen nepatrně. V modelu McCullocha a Pitta měly všechny spoje stejnou váhu a jeden brzdící spoj zcela potlačoval možnost generování potenciálu v daném cyklu (veto). Moderní uzly ANN pro součet excitačních a inhibičních vstupů (s kladnými a zápornými váhami w_xy) používají aktivační funkci z rovnice ([eq:ann]), jejíž tvar není volen s ohledem na shodu s neurobiologií, ale s ohledem na výpočetní efektivitu ANN. Pokrok je dán rostoucí velikostí sítí.

Zcela odlišně vypadá pokrok v úplně jiné oblasti modelování činnosti biologických neuronů. Již v roce 1952 Alan Hodgkin a Andrew Huxley navrhli systém nelineárních diferenciálních rovnic, které zohledňují tok sodíkových a draselných iontů přes membránu neuronu a popisují vznik akčních potenciálů pozorovaných v neuronech (za což o 10 let později získali Nobelovu cenu). Parametry modelu byly vybrány v souladu s výsledky experimentů. Následující desetiletí pokroku v neurobiologii poskytla obrovské množství materiálu, který umožňuje vytvářet prakticky libovolně přesné matematické modely biologických neuronů a simulovat jejich interakce – například pro pochopení příčin neurologických onemocnění. Dosud pro tento účel modelujeme jejich menší nebo větší skupiny a vybíráme stupeň složitosti v závislosti na výzkumných otázkách. Ale pouze relativně malé podskupiny a pouze z hlediska konkrétních účinků.

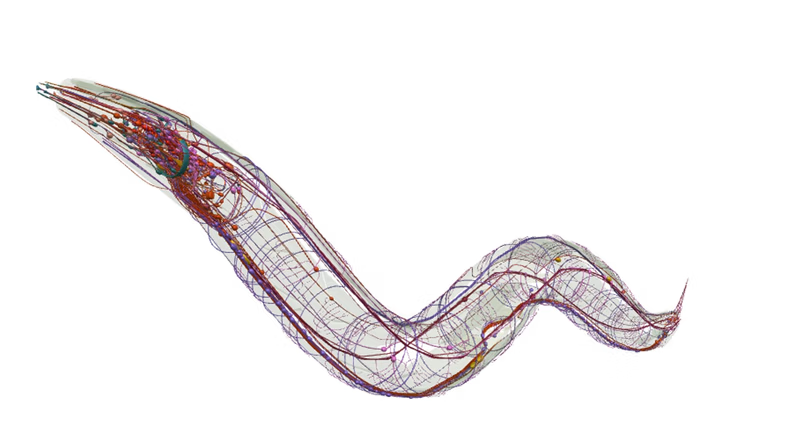

Pokusy o komplexní modelování celých organismů nejlépe odráží již více než čtvrt století trvající práce na nervovém systému hlístice Caenorhabditis elegans (obrázek níže). Proč se právě tento malý (asi 1 mm) červ stal tak populární v neurovědách? Výzkum tohoto organismu je nesrovnatelně jednodušší než výzkum na lidech:

- konektom (tj. kompletní schéma neuronových spojení) C. elegans je znám od roku 1986,

- nervová soustava C. elegans se skládá přesně z 302 neuronů, zatímco lidský mozek z více než 86 miliard,

- všechny červi tohoto druhu mají stejný konektom [tj. mapu neuronových spojení] – mozek každého člověka je jedinečný,

- konektom C. elegans je neměnný – neuroplasticita lidského mozku vede k tomu, že spojení mezi neurony (a samotné neurony) vznikají a mizí.

Vizualizace nervového systému hlístice Caenorhabditis elegans, vygenerovaná na webu http://browser.openworm.org

Cesta od konektomu k reprodukci alespoň základních forem chování (nemluvě o vědomí) je však přinejmenším velmi dlouhá. I v případě tak jednoduchého organismu, jako je C. elegans, jsme stále na samém počátku této cesty, o čemž svědčí například články shrnující diskusi „Connectome to behaviour: modelling C. elegans at cellular resolution”. Jinými slovy, přenesení nervového systému drobného červa do kyberprostoru tak, aby bylo možné reprodukovat alespoň jeho základní chování, je v současné době nemožné a nelze upřímně říci, zda a kdy to bude možné. Právě v tomto kontextu je třeba hodnotit opakující se prohlášení v médiích o emulaci lidského mozku a přenosu vědomí do kyberprostoru.

Chyba extrapolace

Přímé srovnání systémů AI s mozkem je stejně nesmyslné jako nazývat letadla umělými ptáky – neočekáváme, že vyspělé letecké technologie nám přinesou letadla nesoucí vejce. Podobně jsou moderní systémy AI vytvářeny pro plnění konkrétních úkolů, nikoli pro studium a reprodukci fungování lidského mozku.

Vlajkovým projektem v této oblasti byl Human Brain Project, který i přes financování ve výši 1 miliardy eur nesplnil slib Henryho Markrama daný na konferenci TED v roce 2009:

[…] doufám, že jsem vás alespoň částečně přesvědčil, že sestavit mozek není nemožné. Můžeme to dokázat do 10 let, a pokud se nám to podaří, za 10 let pošleme na TED hologram, který s vámi bude mluvit.

Odkud se berou takové nereálné sliby? Bylo by naivní vysvětlovat je chybou extrapolace: již poměrně přesně rozumíme fungování jednotlivých neuronů a interakcím mezi nimi, to znamená, že je můžeme numericky modelovat. Fungování mozku je založeno na interakcích mezi skupinami neuronů. Již dokážeme modelovat jednotlivé aspekty fungování malých skupin – například pro výzkum epilepsie. Mohlo by se tedy zdát, že pokud spustíme dostatečně výkonný počítač, který umožní efektivně modelovat stále větší skupiny neuronů, v určitém okamžiku díky samotnému rozsahu automaticky vznikne nová kvalita, tedy vědomí, a počítač najednou oznámí: „Ahoj, já jsem Ambrozius.“ Nebo dokonce hned:

Dejte mi moc nad dušemi! – Tak pohrdám touto mrtvou konstrukcí

Kterou svět nazývá společenstvím a chválí

To, co jsem dosud nezkusil, tedy své slovo

Nemohl bych ji hned svrhnout.

Ale cítím v sobě, že kdybych stlačil svou vůli

Soustředil a společně osvítil

možná bych uhasil sto hvězd a dalších sto zapálil

— (Adam Mickiewicz, „Strýcové“)

Totéž platí v oblasti AI, kde se rozsah může jevit jako nejdůležitější parametr. Jak jsem již zmínil výše, umělé neuronové sítě se rozvinuly pouze díky dostatečně velkému rozsahu trénovacích dat a výpočetních zdrojů. Proto stovky miliard dolarů a výstavba speciálních jaderných elektráren pro potřeby výpočetních center by měly automaticky vést k vzniku rozsahu, ve kterém se AI stane vševědoucím orákuliem, nejmocnější zbraní a zdrojem nepředstavitelného bohatství. Stejně jako příběhy Henryho Markrama o umělém mozku zajistily miliardu eur na jeho výzkum, příběhy o nadlidské síle, které AI brzy dosáhne, dnes přinášejí stovky miliard investic do těchto technologií.

Křehkost této bubliny prokázalo nedávné zveřejnění nového modelu čínskou společností DeepSeek, který podle tvůrců vyžaduje podstatně méně výpočetních zdrojů než přední modely vytvořené v USA. Společnost Nvidia, která vyrábí integrované obvody potřebné pro výcvik velkých modelů, zaznamenala největší pokles hodnoty v historii americké burzy, a to téměř o 600 miliard dolarů; společnost OpenAI (která navzdory svému názvu nemá nic společného s otevřeností) obviňuje Číňany z toho, že při výcviku využívají výstupy z jejich modelu; autoři a novináři obviňují OpenAI z krádeže duševního vlastnictví tím, že modely učí na datech chráněných autorským právem…

Když nemůžeš vyhrát, připoj se

Dalším způsobem, jakým technologické celebrity slibují zachránit lidstvo před apokalypsou AI, je propojení lidského mozku s křemíkovým. Na první pohled je to jednoduché: rozhraní „mozek-počítač“ (brain-computer interfaces, BCI) existují již mnoho let, vědci na nich pracují, takže stačí přidat pár milionů a je hotovo – v čem je problém?

Vysvětlíme to podrobněji:

BCI byly vytvořeny v minulém století pro lidi trpící neurodegenerativními onemocněními, jako je například laterální amyotrofická skleróza, která zabíjí neurony přenášející informace z mozku, které řídí svaly. Krutost této nemoci spočívá v tom, že mozek sám zůstává relativně nepoškozený, ale navždy uvězněný v pekle (locked-in state), protože veškerá aktivní komunikace je prováděna lidmi prostřednictvím svalů: plic, hrtanu, obličeje nebo rukou. Když je ovládání všech těchto svalů přerušeno, ztrácíme schopnost cokoli vyjádřit. Snad jen záměr lze přečíst přímo z mozku. A to je právě klasická definice BCI: čtení záměrů generovaných v mozku bez zprostředkování svalů.

Jak je číst? Jak jsem již zmínil, zpracování informací mozkem je spojeno s vznikem elektrických potenciálů. Jejich stopy, tedy elektroencefalogram (EEG), čteme z elektrod umístěných na povrchu hlavy již téměř sto let – EEG je dosud nejoblíbenější technikou zaznamenávání procesů probíhajících v mozku. Na EEG byla založena také první veřejná prezentace BCI v Polsku: na fotografii výše je vidět projekce obrazovky notebooku, který jsem tehdy viděl, na kterém postupně blikají řádky a sloupce matice symbolů. Úkolem systému je zjistit, na který znak jsem soustředil pozornost – reakce nastane při rozsvícení příslušného řádku a sloupce. Reakce musí být samozřejmě detekována přímo podle elektrických stop myšlenek, tj. podle EEG.

Tato reakce se nazývá evokovaný potenciál, jev známý v encefalografii již několik desítek let: prohlubeň viditelná po zprůměrování několika nebo několika stovek úseků EEG synchronizovaných se stimulem. Vzhledem k tomu, že podněty jsou generovány počítačem, může k takovému zprůměrování docházet prakticky v reálném čase

Tak fungují moderní BCI: z mozkových aktivit naměřených různými metodami se snaží přečíst (klasifikovat) záměry, kterým můžeme přiřadit více či méně podmíněný význam. To znamená, že k objednání kávy přes BCI nestačí myslet na voňavou šálek, ale je nutné navrhnout rozhraní, ve kterém bude možnost výběru kávy, a přiřadit jí měřitelnou reakci, kterou může uživatel kontrolovat.

Člověk a umělá inteligence

BCI fungují mnohem efektivněji, pokud začnete s kalibrační relací: uživatel je vyzván, aby se soustředil na podněty určené systémem, díky čemuž můžeme optimalizovat klasifikátor. V klasickém přístupu obvykle stačí několik minut takové kalibrace, aby bylo dosaženo skutečné rychlosti práce v řádu desítek znaků za minutu.

Jiná věc je, pokud chceme překonat rychlostní rekordy – Formule 1 v BCI – to je registrace potenciálů zevnitř lebky (elektrokortikografie) a klasifikátory založené na hlubokých neuronových sítích. Aktuální rekord zapsaný v Guinnessově knize rekordů – 78 slov za minutu s 25 % chybovostí – byl dosažen na signálech z 253 elektrod umístěných přímo na mozkové kůře po několika týdnech kalibračních sezení, během nichž se síť učila porovnávat vzorce mozkové aktivity čtené z elektrod se slovy z vybrané sady, která pacientka vyslovovala bez zvuku. Ale stále se jedná pouze o porovnání vzorců neuronové aktivity odpovědné za přípravu pohybů rtů a jazyka s vyslovenými slovy bez zvuku, nikoli o čtení myšlenek.

Skutečnost, že BCI nečtou myšlenky, ale pouze vědomě generované záměry – a to výhradně ve velmi specifických situacích, které vyžadují předchozí vědomou spolupráci pacienta v procesu kalibrace – neměla vliv na množství alarmistických předpovědí o „odposlouchávání myšlenek“ a „konci soukromého života“, které zaplňovaly populární média v době vrcholu popularity BCI před deseti lety. Nezmiňuji tento fakt, abych zesměšňoval dnes módní diskuse o hrozbách AI – tyto hrozby jsou reálné a my se s nimi potýkáme již nyní. Bohužel, hrozby, o kterých mluví celebrity v médiích, jsou obvykle více futuristické a mediální než aktuální a konkrétní. Skutečnými a konkrétními hrozbami spojenými s BCI se zabývá neuroetika, k hrozbám AI se vrátím v následující části.

Internet se rozpaluje téměř výlučně zprávami o dalším (třetím?) pacientovi, který pohybuje kurzorem přes rozhraní Neuralink. Přitom se opomíjí skutečnost, že od okamžiku zveřejnění v roce 2006, tedy dlouho před založením Neuralinku, byly podobné rozhraní implantovány v mnoha vědeckých centrech již několika desítkám pacientů, kteří dokonce vytvořili koalici průkopníků BCI. Neuralink nepřinesl do této oblasti nic nového, kromě deklarovaného zdokonalení samotného procesu implantace – možná to nestačí investorům, díky nimž je společnost oceněna na 8 miliard dolarů? A možná právě proto, v souladu s kultovním aforismem Silicon Valley „fake it till you make it“ (předstírej, dokud nedosáhneš úspěchu), Elon Musk slibuje revoluci v léčbě Parkinsonovy choroby, epilepsie, autismu, obezity, deprese, schizofrenie… V tomto kontextu je třeba také hodnotit sliby přímého propojení mozku s AI.

Apokalypsa AI

Vzhledem k tomu, že v nejbližší budoucnosti není vidět možnost propojení našich mozků s AI nebo přenosu vědomí do kyberprostoru, zbývá se pozorněji zaměřit na hrozby, které pro lidstvo představuje rychlý rozvoj těchto technologií. O tom mluví všichni – od youtuberů až po nositele Nobelovy ceny v oblasti Jeffrey Hinton a Demis Hassabis. Obvykle však poměrně obecně.

Většina apokalyptických předpovědí souvisí s očekávaným příchodem silné (obecné) umělé inteligence (artificial general intelligence, AGI), která brzy překoná lidský intelekt ve všech ohledech. Jakmile získá schopnost jednat, bude jasné, kdo je tady pánem. Nejnovější výzkumy také potvrzují tezi, že se k tomuto bodu blížíme ze dvou stran: zatímco LLM díky komunikaci s lidmi shromažďují stále více dat, lidé, kteří denně používají nástroje AI, zřejmě postupně ztrácejí schopnost kriticky myslet.

Podle scénářů ze sci-fi může apokalypsa AI nastat kvůli nedorozumění. Švédský filozof Nick Bostrom navrhl myšlenkový experiment, ve kterém je řízení továrny na výrobu kancelářských sponek zcela předáno AI s jediným cílem: maximalizovat výrobu. AI správně usoudí, že lidé v tomto procesu mohou jen překážet, a přemění je na sponky.

A tak dále. Rádi posloucháme takové předpovědi, protože (1) se týkají budoucnosti, a proto se většině lidí bohužel zdají stejně neškodné jako globální oteplování, a (2) jakoby nás automaticky zbavují nutnosti přemýšlet – vždyť stejně nemůžeme nic dělat tváří v tvář všemocné AGI.

Nicméně, milý čtenáři, pokud jste dočetli tento článek téměř až do konce, doufám, že oceníte pokus analyzovat skutečné hrozby a škody, které algoritmy související v poslední době s AI již po desetiletí způsobují.

Vláda duší

Hlavním ukazatelem hodnoty a zdrojem obrovských příjmů sociálních sítí je počet aktivních uživatelů a čas, který tráví prohlížením obsahu nabízeného službou. Myšlenka není nová – média vždy bojovala o pozornost uživatelů různými způsoby: od laciných senzací po novinářskou poctivost. Situace se sociálními sítěmi se liší v tom, že autory obsahu jsou ve většině případů uživatelé. To dává důvod k tak pohodlnému, jakkoli neetickému zbavení se odpovědnosti ze strany vlastníků platforem. Tím spíše, že výběr obsahu nabízeného uživatelům sociálních sítí na první stránce, tj. rozhodnutí o tom, které příspěvky budou posilovány a propagovány, přijímají algoritmy.

Tyto algoritmy, které jsou podle současných definic považovány za umělou inteligenci, poměrně rychle „zjistily“, že největší zapojení uživatelů zaručují kruté a antagonistické materiály, přičemž jejich případná věrohodnost má na zapojení v nejlepším případě marginální vliv. Pravda je obvykle méně zajímavá a složitější na pochopení než vymyšlené příběhy. To vede k šíření a zesilování velmi často škodlivého a nepravdivého obsahu. Protiřečení sociálních, etnických skupin a celých národů v tomto případě není součástí tajného plánu – jde pouze o maximalizaci zisku společností, které se i nadále vyhýbají odpovědnosti za důsledky.

A tragické důsledky v tomto případě již nejsou hypotetické, ale konkrétní a zdokumentované. Například genocida a etnické čistky v Barmě v letech 2016–2017, které byly z velké části způsobeny šířením nenávistných projevů ultranacionalistického buddhistického mnicha Ashin Wirathu prostřednictvím Facebooku, jehož atraktivní příspěvky hanobící muslimskou etnickou skupinu Rohingya byly algoritmy zkopírovány a šířeny na rozdíl od nudných názorů mnoha jiných mnichů, kteří volali po soucitu. Empatie se ukázala být méně atraktivní než výzvy k násilí.

Výsledkem, který mimochodem způsobují algoritmy doporučující obsah, je efekt potvrzení (confirmation bias): na webu vidíme pouze obsah, který odpovídá našim přesvědčením a předsudkům, a stáváme se stále více izolovaní od opačných argumentů. Tímto způsobem vede AI k polarizaci sociálních skupin fungujících v oddělených informačních bublinách.

Mikrotargeting

Mikrotargeting je další mechanismus, který se na první pohled jeví jako neškodný a zvyšuje účinnost reklamy. Reklama by nás měla zaujmout konkrétními produkty, ale ne všichni se zajímají o totéž a ne na všechny působí stejné argumenty.

Odkud algoritmy vědí, jak přesvědčit konkrétní lidi? Michal Kosinski ukázal, že patentovaný algoritmus Facebooku „“ je schopen určit sexuální preference (u mužů s účinností 88 % případů), vzhled, zájmy, úroveň inteligence, etnický původ a barvu pleti (u Američanů s účinností 95 % případů), náboženské vyznání, úroveň spokojenosti se životem, závislosti, věk, pohlaví, ale i sociální, náboženské a politické názory (…) na základě 68 lajků na Facebooku.»

Použití technik behaviorální manipulace, přesně zaměřených na individuální strachy a slabosti každého z nás, dává téměř neomezené možnosti formování názorů, včetně ovlivňování výsledků voleb a referend, jejichž objektivita je základem demokracie. Příkladem může být například předpokládaný vliv společnosti Cambridge Analytica na volby v USA a brexit.

Nesnesitelná lehkost falšování

To je již nejnovější historie napsaná generativní AI. Novým jevem nejsou samotné falzifikace, ale prakticky neomezená dostupnost téměř dokonalých nástrojů, které pomocí AI umožňují vytvářet téměř dokonalé falzifikace – prakticky pro každého, bez velkých nákladů nebo speciálních znalostí.

A právě na digitální výměně informací je dnes založena většina komunikace mezi lidmi. Její spolehlivost je pilířem demokracie. Státy ji musí chránit stejně, jako chrání spolehlivost peněz jako společenské smlouvy. Padělání bankovek je vzácné nikoli z technických důvodů, ale kvůli přísné legislativě v této oblasti. Doufejme, že zmíněné usnesení Evropského parlamentu a Rady EU bude fungovat podobně – alespoň v Evropě. Ale to je už jiná historie.